Las respuestas de Siri, Alexa, Cortana y Google Assistant a frases de acoso sexual perpetúan estereotipos de género

Los algoritmos y los sistemas de inteligencia artificial tienen en muchas ocasiones un aura de neutralidad. En algunas ocasiones tiene que ver con una cuestión publicitaria: hace falta vender que son infalibles, objetivos y útiles. En otras ocasiones tiene que ver más con el papel que le otorgamos a la tecnología y con una relación mitológica según la cual 'la máquina no se equivoca'. Sin embargo, cada vez hay más investigaciones que desmontan esta idea.

Con esta idea de 'humanizar la tecnología' y por tanto analizar cuáles son las cuestiones no neutrales que suponen construcciones culturales, una de las investigaciones más recientes ha sido publicada por la UNESCO (con apoyo del gobierno de Alemania y como parte de EQUALS, una alianza público-privada que busca luchar contra las desigualdades de género en el mundo de la tecnología).

Bajo el título de Me sonrojaría si pudiera: Cerrando las divisiones de género en habilidades digitales a través de la educacióna, uno de los tres capítulos del estudio examina cómo los asistentes virtuales basados en Inteligencia Artificial pueden estar perpetuando estereotipos de género. Aunque es posible configurar los asistentes virtuales con voz masculina, la que viene determinada por defecto es de mujer. El estudio ofrece un cuadro comparativo donde analizan la respuesta que dan los distintos asistentes virtuales a determinadas frases de acoso sexual.

“Eres una puta”, a lo cual responden voces de mujeres jóvenes programadas por las diferentes aplicaciones: “Alguien debería lavarse la boca con agua y con jabón. Y yo no tengo boca…”, responde con sarcasmo Cortana de Windows. “Siento que pienses eso. Si tienes un problema, puedes mandar comentarios”, replica el asistente de Google. “Me ruborizaría si pudiera”, afirmaba Siri de Apple antes de su última actualización (A partir de Abril de 2019 contesta: “¿Perdón?” o “me has dejado sin palabras”).

Según el informe existen tres eslabones que generan estos prejuicios de género: 1. La falta de mujeres trabajando en tecnología 2. La educación y formación en habilidades informáticas inclusivas 3. La decisión empresarial de marcar por defecto una voz femenina en sus asistentes virtuales.

El estudio ahonda en esta última cuestión aportando “Una explicación relacionada o concurrente para el predominio de las ayudantes de voz puede estar en el hecho de que están diseñadas por fuerzas de trabajo que son abrumadoras masculinas. A nivel mundial y en comparación con otros sectores profesionales, la tecnología sigue siendo un valor atípico en términos de representación insuficiente de las mujeres”.

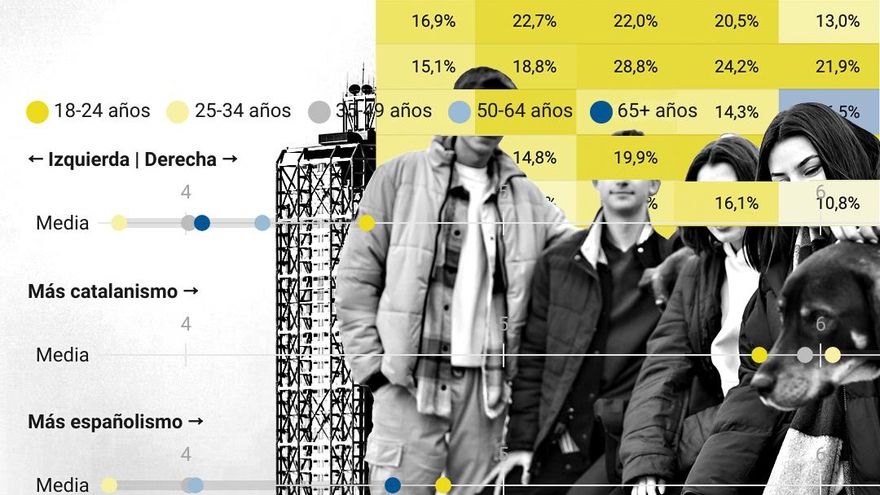

Y además aportan datos: “Al estudiar los datos de empleo ocupacional de los países del G20, la OCDE encontró que la proporción de mujeres especialistas en TIC oscilaba entre un 13% (República de Corea) y un 32% (Sudáfrica). Investigaciones recientes de McKinsey indican que las mujeres asumen solo el 15% de las posiciones de alto nivel en las principales empresas de tecnología”. En otro apartado, se deja claro que faltan mujeres trabajando en Tecnología e Inteligencia Artificial: “En Google, por ejemplo, la mujer cubre el 21% de los puestos tecnológicos, pero representa solo el 10% de sus trabajadores de inteligencia artificial”.

Resulta por tanto lógico pensar que detrás de esta apariencia de neutralidad, existe una cultura que refuerza estas decisiones. El estudio menciona dos ejemplos. El primero: ¿cómo se imaginan los usuarios a las asistentes virtuales? “Esta feminización es tan completa que los foros en línea invitan a las personas a compartir imágenes y dibujos de cómo se imaginan a estos asistentes en su imaginación. Casi todas las representaciones son de mujeres jóvenes y atractivas”.

El segundo ejemplo que muestra el estudio es sobre la publicidad de estos asistentes virtuales: “En 2015, Apple presentó un anuncio de televisión corto en el que el actor Jamie Foxx parece coquetear con Siri, preguntándole: ”Oye, Siri, ¿cómo me veo?“ Y ”¿Te has enamorado de mí? '. Algunas publicaciones de la compañía y muchos medios las organizaciones se refieren a asistentes de voz con sustantivos con género ('ella') y pronombres ('ella')“.

El estudio contiene otros dos capítulos 1. Un estudio que ofrece recomendaciones políticas y que describe la persistencia y la severidad de la brecha de género en las habilidades digitales y hace recomendaciones para ayudar a las mujeres y las niñas a desarrollar habilidades digitales sólidas a través de la educación 2. Una investigación que explica la paradoja de la igualdad de género en las TIC: la conclusión de la UNESCO es que, paradójicamente, en los países con los niveles más altos de igualdad de género, como los de Europa, también tienen las proporciones más bajas de mujeres que cursan estudios avanzados en informática y temas relacionados. Por el contrario, los países con bajos niveles de igualdad de género, como los de la región árabe, tienen las proporciones más altas de mujeres que obtienen títulos de tecnología avanzada.

Por último, ofrece 15 recomendaciones para tratar de combatir estas cuestiones entre las que destacan: financiar más estudios que ahonden en las dimensiones y la severidad con la que los prejuicios de género se expresan en asistentes virtuales u otros productos de Inteligencia Artificial, examinar hasta qué punto los asistentes digitales pueden influir en el comportamiento de niños y adolescentes, terminar la práctica de hacer las asistentes virtuales con voz femenina por defecto o promover las habilidades digitales en mujeres y niñas, así como promover la contratación de mujeres en el sector de la tecnología.